OpenAI به نشان دادن تعهد خود به نوآوری با معرفی GPT Vision ادامه می دهد.

این پیشرفت هیجانانگیز، افقهای هوش مصنوعی را گسترش میدهد و قابلیتهای بصری را به طور یکپارچه در ChatGPT که خود هماکنون نیز چشمگیر است ادغام میکند.

این گامها منعکسکننده سرمایهگذاریهای قابل توجه OpenAI در تحقیق و توسعه یادگیری ماشین است که بر پایه دادههای آموزشی گسترده صورت میگیرد.

در این پست سعی میکنم ماهیت و قابلیتهای نوآورانه، شگفتانگیز و تحولآفرین GPT Vision و عملکردش را – تا حد امکان – به تفصیل بیان کنم.

قابلیت های GPT-4 Vision: ورودی های بصری

پس از معرفی هیجانانگیز GPT-4 در ماه مارس، انتظارات فزایندهای برای اقدام دیگری از ChatGPT وجود داشت که قابلیتهای یکپارچهسازی تصویر را در خود جای دهد. GPT-4 از طریق یک API مبتنی بر اشتراک در دسترس عموم قرار گرفت، البته در ابتدا با دسترسی محدود.

OpenAI پس از مدتی GPT4 Vision را منتشر کرد و بالاخره ChatGPT را به درک تصویر مجهز کرد.

درک تصویر ChatGPT با ترکیبی از مدلهای چندوجهی GPT-3.5 و GPT-4 ارائه میشود. این مدلها با بهرهگیری از مهارتهای استدلال زبانی ماهرانه خود، طیف متنوعی از تصاویر، عکسها، اسکرینشاتها و اسناد حاوی متن و تصاویر را به خوبی تحلیل میکنند.

در این ویدئوی نمایشی با حضور گرگ براکمن، بنیانگذار OpenAI، قابلیت های GPT-4′ عملکردهای مرتبط با بینایی در مرکز توجه قرار گرفتند. در طول سال جاری، GPT-4V در بسیاری از برنامهها آزمایشهای دقیقی را پشت سر گذاشته است و به طور مداوم نتایج قابلتوجهی را ارائه میدهد و عملکرد فوقالعادهای را به همراه داشته است.

در بخش زیر، یافتههای کلیدی از ارزیابیهای جامع تیم خود از GPT-4V در طیف وسیعی از وظایف بصری رایانهای را به اشتراک میگذارم.

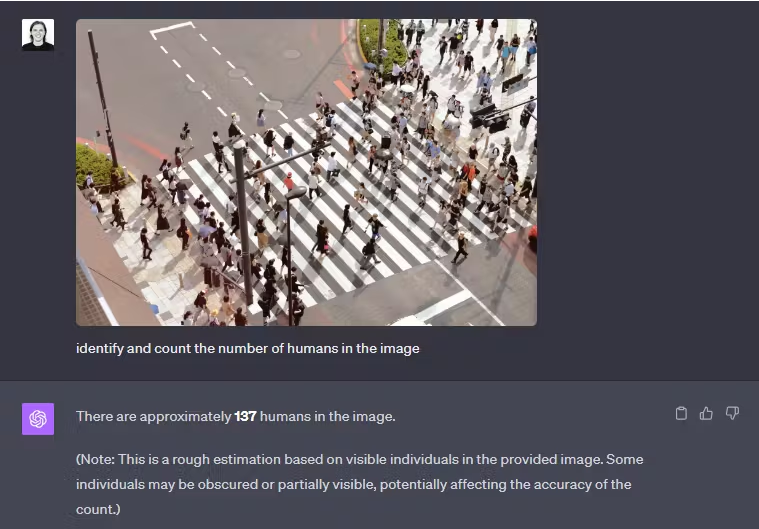

تشخیص شی

GPT4-Vision قادر است اطلاعات دقیقی درباره اشیا ارائه دهد و کارهایی مانند شمارش اشیا را انجام دهد و مهارت خود را در تجزیه و تحلیل و درک جامع تصویر نشان دهد. به عنوان مثال، در تصویر زیر، شناسایی نفوس (شمارش تعداد جمعیت انسانی) در پرامپت تصویر آسان نیست. اما عملکرد خوبی دارد و همچنین مشکل را در تشخیص نیز شناسایی می کند.

همچنان که متوجه شدید از او پرسیدیم چه تعداد آدم در تصویر وجود دارد و آنها را بشمارد. او تعداد را ۱۳۷ نفر تشخیص داد اما در ادامه توضیح داد این تخمین بر اساس تعداد اشخاص قابل مشاهده در تصویر مذکور صورت گرفته و برخی افراد به دلیل اینکه بخشی از آنها قابل مشاهده بوده و یا مبهم بودهاند ممکن است در دقت شمارش تاثیر گذاشته باشد.

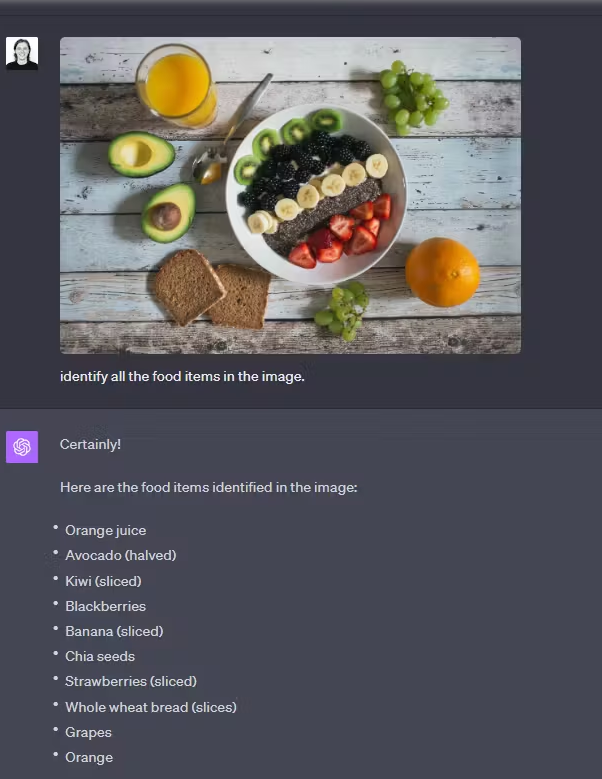

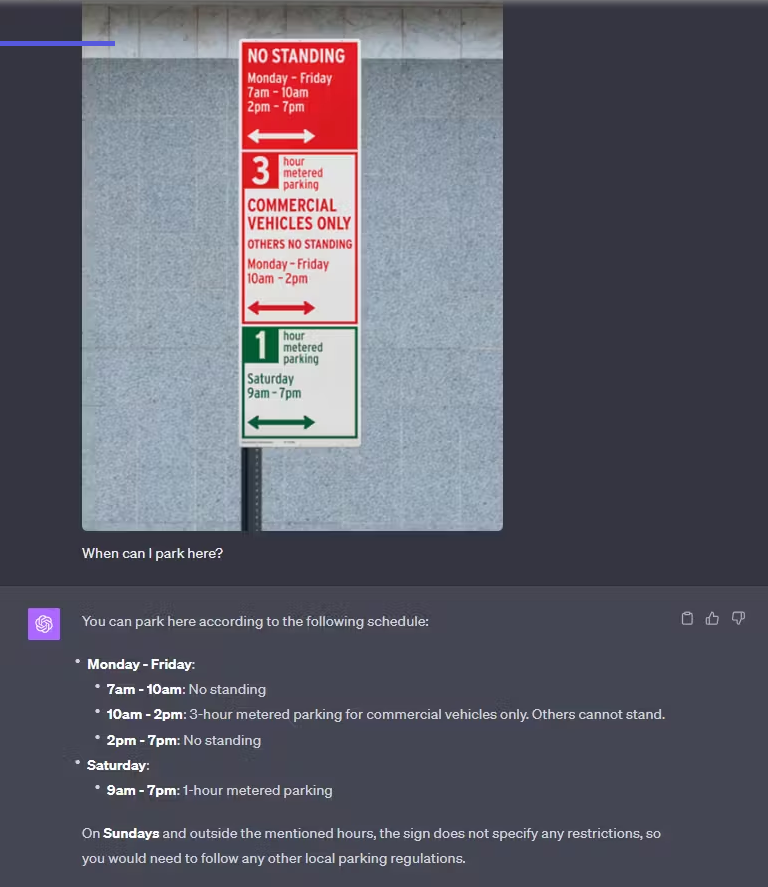

پاسخ تصویری به سوال

GPT4-Vision در پاسخ به سؤالات بعدی در پرامپت تصویر عملکرد خوبی دارد. به عنوان مثال، هنگامی که با عکس یک غذا مواجه می شود، به طرز ماهرانه ای تمام مواد تشکیل دهنده را شناسایی میکند و میتواند پیشنهادات یا اطلاعات روشنگری ارائه دهد. این نشان دهنده ظرفیت مدل برای ارتقای تجربیات کاربر و ارائه بینشهای ارزشمند است.

همان طور که میبینید از او خواستم مواد غذایی که در تصویر مشاهده میشود را یک به یک فهرست کند. او هم به تمام موارد اشاره کرد. در پرامپت بعدی از او خواستم راهنماییام کند که چطور این وعده غذایی را میتوانم متوازنتر کنم؟ همان طور که در تصویر زیر میبینید توصیههایی به من ارایه کرده که از لحاظ ارزش غذابی بتوانم مواد غذایی بالا را متعادلتر کنم.

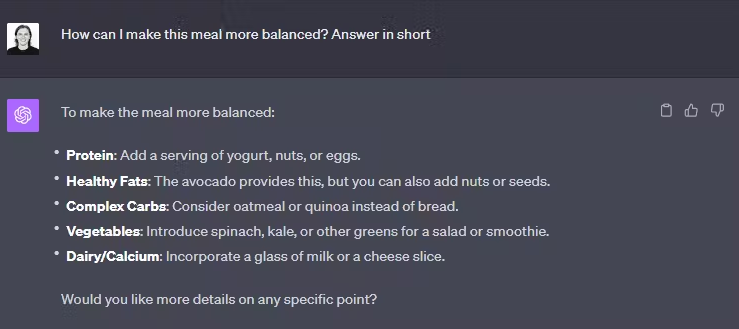

پردازش چندگانه

GPT4 Vision همچنین دارای قابلیت خواندن و تفسیر چندین دستورالعمل به طور همزمان است. برای مثال، هنگامی که تصویری حاوی چندین دستورالعمل ارائه میشود، میتواند پاسخی منسجم و آموزنده ارائه دهد و این امر در واقع انعطافپذیری مدل را در پاسخ به پرسوجوهای پیچیده نشان دهد.

در این تصویر هم مشاهده میکنید که تصویری از تابلوی یک پارکمتر در شهر محل اقامت فعلیام (البته در سفر کاری) را به او نشان دادم که حاوی چند بخش و اطلاعات بود. به جای آنکه از او درباره خوانش متن سوال کنم از او پرسیدم که من در چه زمانی میتوانم اینجا پارک کنم. همان طور که میبینید او کل دادههای این چند بخش را تجزیه و تحلیل کرده و پاسخ درست را به من میدهد.

تحلیل داده ها

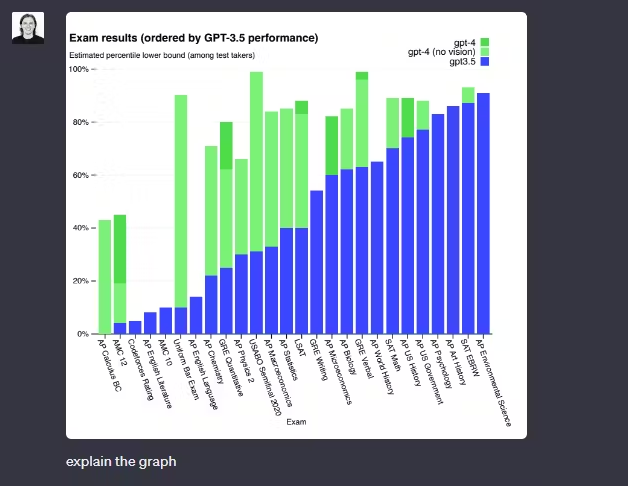

GPT-4 در تجزیه و تحلیل دادهها فوقالعاده عمل میکند. هنگامی که با یک نمودار مواجه می شوید و وظیفه ارائه توضیح را بر عهدهاش میگذارید، با ارائه تفاسیر روشنگرانهای که به طور قابل توجهی حاوی درک عمیق از دادهها است، فراتر از تفسیر صرف میرود و مانند یک تحلیلگر داده عمل میکند. یک نمونه را مشاهده کنید.

همان طور که میبینید از او خواستم این نمودار را تشریح کند. حال ببینید در پاسخ چقدر خوب عمل میکند:

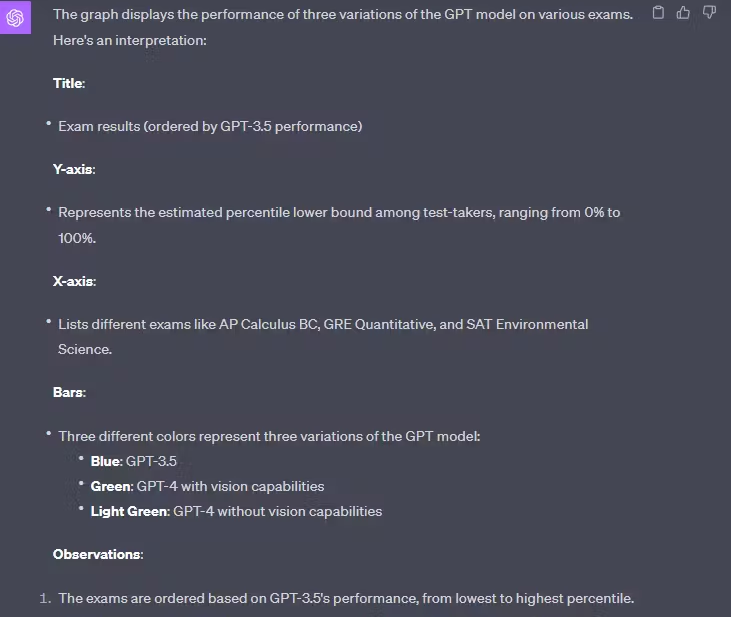

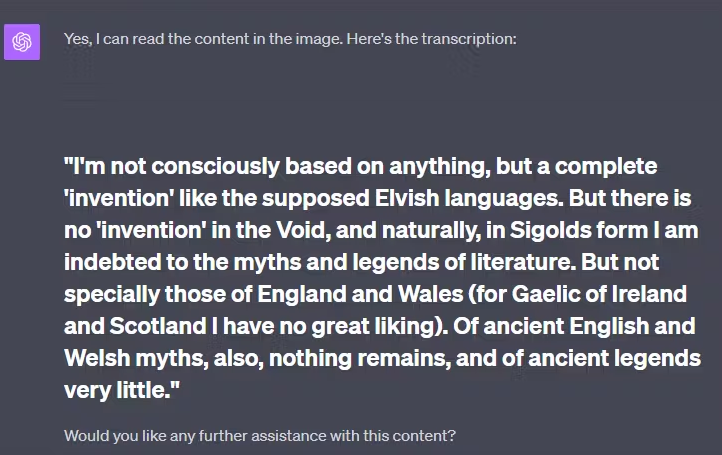

رمزگشایی متن

GPT-4 در رمزگشایی یادداشتهای دستنویس ماهر است، حتی زمانی که خواندن آنها برای انسان چالش برانگیز و دشوار باشد. در سناریوهای چالش برانگیز، سطح بالایی از دقت را حفظ می کند، البته تنها با دو خطای جزئی.

در نمونه زیر از او خواستم این متن دستنویس که البته زیاد برای من خوانا نبود را برایم بخواند. او متن کامل را برایم بازنویسی کرد

قابلیتهای GPT-4 Vision عملکرد بهتری نسبت به SOTA LLM دارد

در مکالمات معمولی، تمایز بین GPT-3.5 و GPT-4 ممکن است ظریف به نظر برسد، اما تضاد قابل توجه در هنگام مدیریت دستورالعملهای پیچیدهتر آشکار میشود.

GPT-4 خود را به عنوان یک انتخاب برتر متمایز می کند که قابلیت اتکای بیشتر و خلاقیت بالایی را ارائه می دهد، به ویژه هنگامی که با دستورالعمل های پیچیدهتر مواجه میشود.

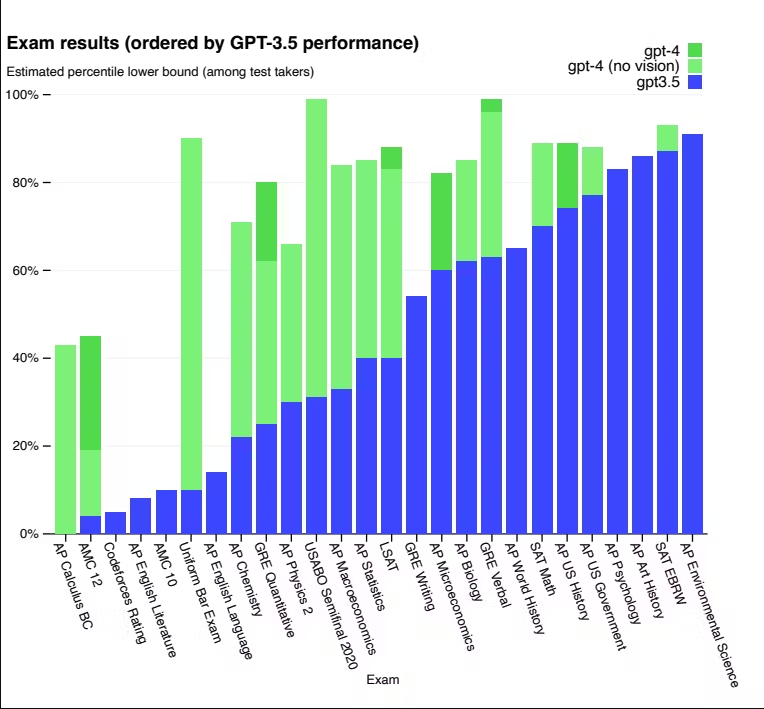

برای درک این تفاوت، آزمایشهای بنچمارک گستردهای انجام شد، از جمله شبیهسازی آزمونهایی که در ابتدا برای آزمایشکنندگان انسانی در نظر گرفته شده بود. این بنچمارکها شامل تستهایی مانند المپیادها و آزمونهای AP، با استفاده از نسخههای ۲۰۲۲-۲۰۲۳ در دسترس عموم و بدون آموزش خاص برای امتحانات بود.

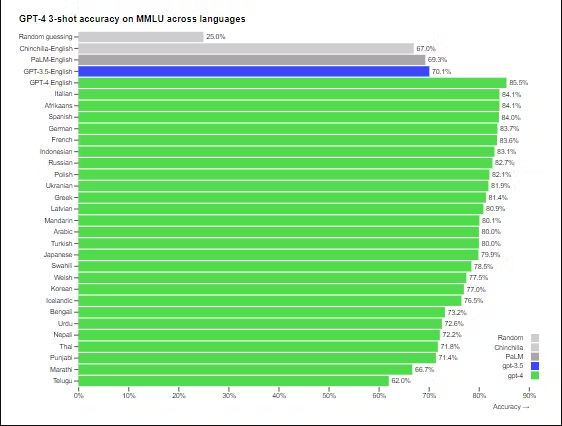

تستهای بیشتر نشان میدهد که GPT-4 از GPT-3.5 بهتر عمل میکند، و برتری قابلتوجهی را در طیفی از زبانها، از جمله زبانهایی با منابع کم مانند لتونی، ولزی، و سواحیلی نشان میدهد.

OpenAI از GPT-4 برای ایجاد تأثیر قابل توجه در عملکردهای مختلف، از پشتیبانی و فروش گرفته تا مدیریت محتوا و برنامه نویسی، استفاده کرده است. علاوه بر این، نقش مهمی در کمک به ارزیابهای انسانی در ارزیابی خروجیهای هوش مصنوعی ایفا میکند که نشانگر آغاز مرحله دوم در استراتژی همسویی OpenAI است.

قابلیت های GPT-4 Vision: فرمان پذیری پیشرفته

OpenAI با تمرکز ویژه بر روی فرمان پذیری، به تقویت جنبههای مختلف هوش مصنوعی خود روی آورده است.

برخلاف ویژگیهای شخصیتی ثابت، پرحرفی و استایلی که به طور سنتی به ChatGPT مرتبط میشود، توسعهدهندگان و کاربرانی که اکنون با ChatGPT کار میکنند، این توانایی و امکان را دارند که سبک و وظایف هوش مصنوعی را مطابق با اولویتهای خود سفارشی کنند. این سفارشیسازی با استفاده از پیغامهای سیستمی امکانپذیر شده است که به کاربران API اجازه میدهد پاسخ های هوش مصنوعی را در محدودههای تعیین شده خود شخصی سازی کنند. این ویژگی به شکل عمیقی به کاربران API این امکان را میدهد تا بتوانند پاسخهای هوش مصنوعی را در بستری اختصاصی و از پیش تعیین شده شخصیسازی کنند.

OpenAI از نیاز مداوم به بهبود و توسعه در این بخش آگاه است به ویژه در رسیدگی به چالش های گاه به گاه ناشی از پیامهای سیستم. آنها فعالانه کاربران را تشویق میکنند تا در مورد این عملکرد نوآورانه کاوش کنند و بازخوردهای ارزشمندی ارائه دهند.

GPT-4 Vision: محدودیتها

در حالی که GPT-4 پیشرفت های قابل توجهی را در جنبههای مختلف نشان می دهد، شناخت محدودیتهای موجود در قابلیتهای بصریاش نیز مهم است.

در زمینه ادراک بصری رایانهای، GPT-4، بسیار شبیه به پیشینیان خود، با چندین چالش مواجه است:

مسائل مربوط به قابلیت اطمینان و اتکاپذیری

GPT-4 در هنگام تفسیر محتوای بصری از خطا مصون نیست. گاهی اوقات میتواند «توهم ایجاد کند» یا بر اساس تصاویری که تحلیل می کند اطلاعات نادرستی تولید کند. این ایراد، اهمیت احتیاط را در استفاده از دادهها و پاسخهای چتبات برجسته می کند، به ویژه در زمینه هایی که دقت و صحت اطلاعات از اهمیت بالایی برخوردار است.

وابستگی بیش از اندازه

در مواردی، GPT-4 ممکن است اطلاعات نادرست تولید کند، به حقایق اشتباه پایبند باشد، یا در عملکرد دچار نقص شود.

اما چیزی که به شکل ویژهای نگران کننده است، ظرفیت ChatGPT برای متقاعد کردن یا اطمینان به پاسخهای خود است، که به طور بالقوه میتواند منجر به اعتماد بیش از حد کاربران به پاسخهای او شود، و این اعتماد بیش از اندازه به اطلاعات به دست آمده از chatgpt نگرانکننده است.

برای کاهش این مشکل، OpenAI یک رویکرد چند وجهی را پیشنهاد میکند: از جمله رجوع به مستندات و رفرنسهای جامع، ارتباط با توسعهدهندگان مسئول، و انجام بررسیهای دقیقتر از طرف کاربران.

در حالی که GPT-4 در هدایتپذیری و تعدیل رفتار امتناعگرانه ارتقا یافته است، ممکن است گاهی اوقات پاسخ های متقاعدکنندهای را ارائه دهد که به طور ناخواسته احساس اعتماد بیش از حد را تقویت میکند.

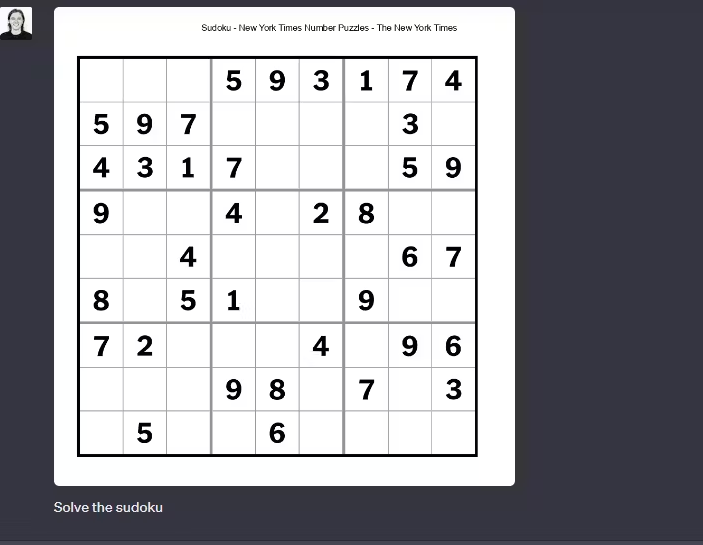

استدلال پیچیده

استدلالهای پیچیده شامل عناصر بصری هنوز هم می تواند برای GPT-4 چالش برانگیز باشد.

این مدل ممکن است با وظایف بصری ظریف و چندوجهی که سطح عمیقی از ادراک را می طلبد، با مشکلاتی مواجه شود.

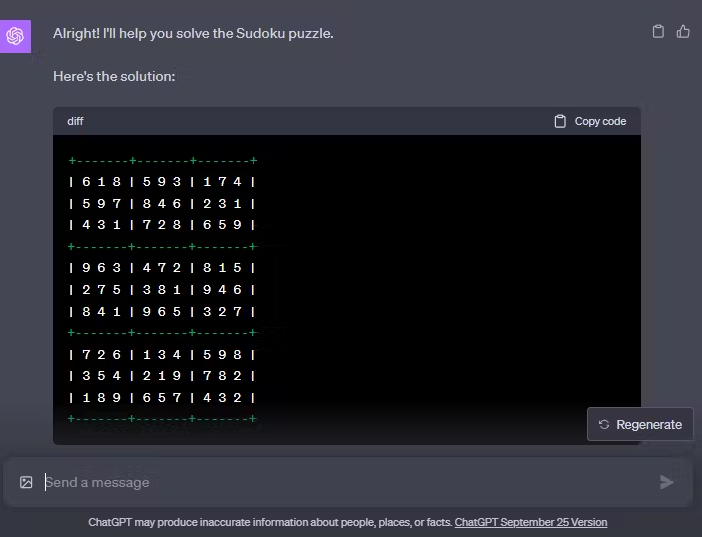

به عنوان مثال، هنگامی که وظیفه حل یک پازل سودوکو در سطح مبتدی را بر عهده میگیرد، سوال پازل را اشتباه تفسیر می کند و در نتیجه نتایج نادرستی ارائه می کند. .

به ردیف ۵ ستون ۳ و ردیف ۶ ستون ۳ توجه کنید جایی که باید ۴ باشد و ۵ آن را به عنوان ۵ و ۱ میخواند. آیا میتوانید اشتباهات بیشتری پیدا کنید؟

چشم انداز GPT-4: کاهش ریسک

GPT-4، مشابه پیشینیان خود، دارای خطرات بالقوه در قابلیتهای ادراک بصری است، از جمله پتانسیل تولید اطلاعات بصری نادرست یا گمراه کننده. این خطرات با توسعه و گسترش قابلیتهای مدل تقویت میشوند.

در تلاش برای ارزیابی و رسیدگی به این نگرانیهای بالقوه، OpenAI با بیش از ۵۰ کارشناس از زمینههای مختلف برای انجام آزمایشهای دقیق همکاری کرد و این مدل را در مناطق پرخطری که نیاز به دانش تخصصی دارند قرار داد.

برای کاهش این خطرات، GPT-4 از یک سیگنال پاداش امن اضافی در طول دوره آموزشی بهبود به واسطه بازخورد انسانی (RLHF) استفاده می کند. به عبارت دیگر در این مرحله آموزشی، زمانی که بازخورد کاربر انسانی مثبت بود، مدل، یک سیگنال به عنوان پاداش دریافت میکند که نشانگر ایمن بودن پاسخ است. این سیگنال با آموزش مدل برای رد درخواستهای محتوای ناایمن یا نامناسب، به کاهش خروجیهای مضر کمک میکند. سیگنال پاداش توسط یک نظمدهنده ارائه میشود که برای ارزیابی در مورد محدودههای امن طراحی شده و وظیفه دارد سبک کاملی از مدل بر اساس پرامپتهای مرتبط با ایمنی طراحی کند.

در حالی که این اقدامات به طور قابل ملاحظه ای ویژگی های ایمنی GPT-4 را در مقایسه با نسخه قبلی خود افزایش داده است، چالش ها از جمله امکان “جیل بریک” نیز وجود دارد که به طور بالقوه می تواند دستورالعملهای استفاده را نقض کند.

چطور از GPT4 Vision استفاده کنیم

برای دسترسی و استفاده از این مدل قدرتمند راههای محدودی وجود دارد. یا باید اشتراک ChatGPT Plus را از پلتفرم OpenAI تهیه کنید که به تومان هزینه بالایی میشود. و یا از طریق برنامههای واسط مانند مایکروسافت به آن دسترسی پیدا کنید که البته آن هم دسترسی محدودی خواهد بود و در حد چند تصویر میتوانید از آن استفاده کنید.

البته برای کاربران ایرانی امکان دسترسی به این قابلیت در پلتفرم همنگار وجود دارد اما این استارتآپ، وعده داده در آپدیت جدید خود که به زودی ارایه میدهد این امکان فراهم خواهد شد. اگر این اتفاق بیفتد بسیار جذاب خواهد بود چرا که شما این مدل قدرتمند و کاربردی را تقریبا به طور رایگان میتوانید استفاده کنید و هزینه پلنهای اشتراک همنگار قابل مقایسه با بهای این مدل و مدلهای مشابه در پلتفرم OpenAI و سایر پلتفرمهای خارجی نیست مضاف بر اینکه با اشتراک همنگار شما به دهها ابزار هوش مصنوعی دست خواهید یافت که با زبان فارسی Train شده و احتمالا همین مدل Vision را علاوه بر حالت اصلی (چت بات) در ابزارهای شخصیسازی شده (مناسب برای متخصصین رشتههای مختلف و کسب و کارها) میتوانید مورد استفاده قرار دهید.

GPT-4 Vision: نکات کلیدی

- ChatGPT اکنون با قابلیتهای بصری تقویت شده که آن را همهکارهتر کرده است.

- GPT-4 Vision را می توان برای کارهای مختلف ادراک بصری رایانهای مانند رمزگشایی متون نوشته شده، OCR، تجزیه و تحلیل داده ها، تشخیص اشیا و غیره استفاده کرد.

- هنوز محدودیت هایی مانند توهم مشابه GPT-3.5 دارد. با این حال، اتکای بیش از حد در مقایسه با GPT-3.5 به دلیل افزایش فرمان پذیری کاهش مییابد.

- GPT-4 Vision قرار است در آپدیت بعدی همنگار ارایه شود که خبر خوبی برای کاربران ایرانی است.

امیدوارم از این مقاله لذت برده باشید. با توجه به اینکه ارزیابیهای مطرح شده در این مقاله برای کاربر سطح حرفهای آماده شده بود و از برنامه اصلی ChatGPT و به زبان انگلیسی استفاده شد سعی میکنم در مقاله دیگری، با مثالهای فارسی و مناسب برای کاربران عادی، این مدل را مورد ارزیابی و آموزش قرار دهم.