در ماه می، مدیران عامل سه تا از برجستهترین آزمایشگاههای هوش مصنوعی -OpenAI، Google DeepMind و Anthropic- یک بیانیه امضا کردند که هشدار میداد هوش مصنوعی می تواند به اندازه بیماری های همه گیر و جنگ هسته ای برای بشریت خطرناک باشد. برای جلوگیری از فاجعه، بسیاری از شرکتها و محققان هوش مصنوعی در مورد محدودیتهایی در مورد اینکه چه کسی میتواند به قدرتمندترین مدلهای هوش مصنوعی دسترسی داشته باشد و چه کسی میتواند آنها را در وهله اول توسعه دهد بحث میکنند. آنها نگران هستند که بازیگران بد بتوانند از مدلهای هوش مصنوعی برای ایجاد مقادیر زیادی اطلاعات نادرست استفاده کنند که میتواند نتایج انتخابات را تغییر دهد، و اینکه در آینده، مدلهای قویتر هوش مصنوعی میتوانند به انجام حملات سایبری یا ایجاد سلاحهای زیستی کمک کنند.

اما همه شرکت های هوش مصنوعی موافق نیستند. در روز پنجشنبه، متا Code Llama را منتشر کرد، خانوادهای از مدلهای هوش مصنوعی که بر روی Llama 2، پرچمدار مدل زبان بزرگ متا ساخته شدهاند، با آموزشهای اضافی برای کاربردی کردن آنها برای کارهای کدنویسی.

بزرگترین و تواناترین مدلهای خانواده Code Llama در معیارهای کدنویسی از سایر مدلهای در دسترس بهتر عمل میکنند و تقریباً با GPT-4، تواناترین مدل زبان بزرگ OpenAI مطابقت دارند. مانند سایر مدلهای هوش مصنوعی که Meta توسعه میدهد، مدلهای زبان Code Llama برای دانلود در دسترس هستند و برای استفاده تجاری و تحقیقاتی رایگان هستند. در مقابل، سایر توسعه دهندگان برجسته هوش مصنوعی، مانند OpenAI و Anthropic ، فقط به کسب و کارها و توسعه دهندگان اجازه دسترسی محدود و پولی به مدل های خود را می دهد که به گفته آزمایشگاه های هوش مصنوعی به جلوگیری از سوء استفاده از آنها کمک می کند. (همچنین به درآمدزایی کمک می کند.)

ماههاست که متا مسیر متفاوتی را برای سایر شرکتهای بزرگ هوش مصنوعی طراحی کرده است. وقتی Meta مدل هوش مصنوعی LLaMA با زبان بزرگ خود را در ۲۴ فوریه منتشر کرد، در ابتدا اجازه دسترسی به پژوهشگران را به صورت موردی داد. اما تنها یک هفته بعد، وزنهای LLaMa – توصیف ریاضی کامل مدل – به صورت آنلاین به بیرون درز کرد.

در ماه ژوئن، سناتورهای آمریکایی ریچارد بلومنتال و جاش هاولی، رئیس و عضو ارشد کمیته فرعی قضایی سنا در خصوص حریم خصوصی، فناوری و قانون، نامه نوشتند. خطاب به مارک زاکربرگ، مدیر عامل متا، با اشاره به این که “به نظر می رسد متا حتی پیامدهای اخلاقی انتشار عمومی خود را در نظر نگرفته است” و به دنبال اطلاعاتی در مورد این فاش شد و از اینکه متا نحوه انتشار مدل های هوش مصنوعی را در آینده تغییر خواهد داد یا خیر. .

یک ماه بعد، متا با آزاد کردن Llama 2 با قاطعیت پاسخ داد. این بار، متا اصلاً تلاشی نکرد تا دسترسی را محدود کنید—همه می توانند مدل را دانلود کنند.

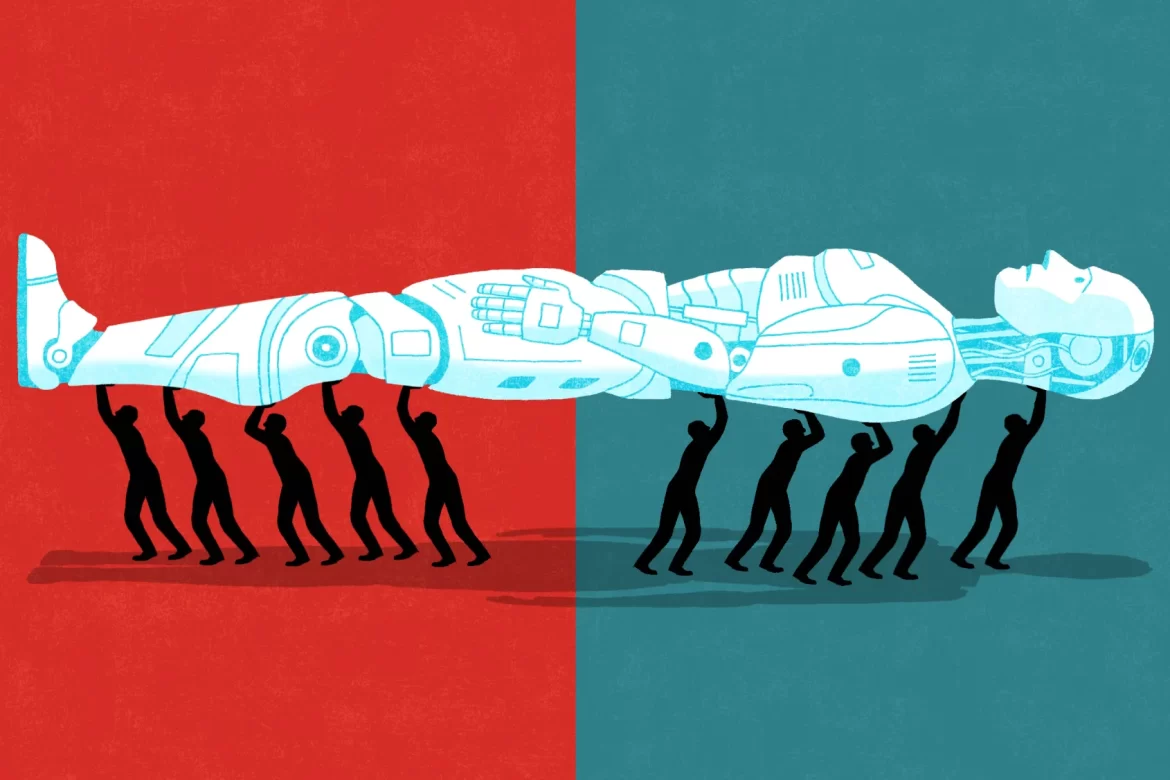

اختلاف بین متا و سناتورها تنها آغاز بحثی است که بر سر اینکه چه کسی میتواند دسترسی به هوش مصنوعی را کنترل کند، پیامدهای گستردهای خواهد داشت. از یک طرف، بسیاری از شرکتهای برجسته هوش مصنوعی و اعضای جامعه امنیت ملی، نگران خطرات ناشی از سیستمهای هوش مصنوعی قدرتمند و احتمالاً انگیزههای تجاری، برای محدودیتهایی در مورد افرادی که میتوانند قویترین سیستمهای هوش مصنوعی را بسازند و به آنها دسترسی داشته باشند، فشار میآورند. از سوی دیگر، یک ائتلاف بعید متا، و بسیاری از مترقیان، آزادیخواهان، و لیبرال های قدیمی، که برای آنچه که می گویند یک رویکرد باز و شفاف برای توسعه هوش مصنوعی است، مبارزه می کنند.

رگولاتورهای مدل مرزی

گروهی از دانشگاهیان و محققان شرکتها در مقالهای با عنوان مقررات مدل مرزی، که در ژوئیه در Arxiv منتشر شد و بازنشر شد در وبسایت OpenAI از جمله OpenAI، Google و DeepMind راههایی را ارائه میکنند که از طریق آن سیاستگذاران میتوانند به این هدف دست یابند. به عنوان مثال، گروهی از دانشگاهیان و محققان از شرکتهایی مانند OpenAI، Google و DeepMind راههایی را ارائه میکنند که از طریق آنها سیاستگذاران میتوانند به این هدف دست یابند. دو نوع اول مداخله توصیف شده – توسعه استانداردهای ایمنی و اطمینان از دید کافی تنظیم کننده ها – نسبتاً بحث برانگیز هستند.

اما این مقاله همچنین راههایی را پیشنهاد میکند که تنظیمکنندهها میتوانند اطمینان حاصل کنند که شرکتهای هوش مصنوعی از استانداردهای ایمنی و الزامات دید پیروی میکنند. یکی از این راهها این است که توسعهدهندگان هوش مصنوعی را ملزم به دریافت مجوز قبل از آموزش و استقرار قویترین مدلها کنیم که به آنها مدلهای مرزی نیز گفته میشود. هنگامی که سم آلتمن، مدیر عامل OpenAI، در جلسه استماع کمیته سنا در ماه مه یک رژیم مجوز را پیشنهاد کرد، بسیاری از مفسران با این موضوع مخالفت کردند. Clément Delangue، مدیر عامل Hugging Face، شرکتی که ابزارهایی را برای ساخت برنامههای کاربردی با استفاده از یادگیری ماشین توسعه میدهد و از رویکرد منبع باز حمایت میکند، استدلال کرد که مجوز می تواند تمرکز صنعت را افزایش دهد و به نوآوری آسیب برساند.

مقاله را می توان به عنوان بیانیه حمایت از رویکرد گسترده ای که در مقاله توسط آن شرکت ها بیان شده است، خواند. در یک نظر در یک فروم اینترنتی، مارکوس آندرلیونگ، رئیس سیاست در مرکز مدیریت هوش مصنوعی و یکی از نویسندگان اصلی مقاله ، توضیح داد که اگرچه او فکر می کند احتمالاً یک رژیم مجوز لازم است، توصیه های مقاله به منظور اطمینان از حضور تعدادی از نویسندگان قطعی تر شده است.

با این حال، حتی در میان شرکتهای هوش مصنوعی که نگران خطرات شدید سیستمهای هوش مصنوعی قدرتمند هستند، پشتیبانی از صدور مجوز به اتفاق آرا نیست. منبعی در آنتروپیک که با مذاکرات در مورد این مقاله در میان آزمایشگاهها آشناست، به TIME میگوید که در آنتروپیک اتفاق نظر وجود داشت که هنوز برای بحث در مورد مجوز خیلی زود است، و آنتروپیک ترجیح داد در میان نویسندگان همکار به دلیل تمرکز بر روی این موضوع حضور نداشته باشد. صدور مجوز برای سایر اقدامات بالقوه مانند مسئولیت جرم. جک کلارک، یکی از بنیانگذاران Anthropic، قبلاً گفته بود صدور مجوز “سیاست بد” خواهد بود.

مروج متن باز

در پست وبلاگ که همراه با انتشار Llama 2 بود، متا توضیح داد که آنها طرفدار یک رویکرد باز هستند زیرا احتمال بیشتری دارد که تبلیغ شود. نوآوری و به این دلیل که یک رویکرد باز در واقع ایمن تر خواهد بود زیرا مدل های AI منبع باز به این معنی است که “توسعه دهندگان و محققان می توانند آنها را آزمایش کنند، مشکلات را به سرعت شناسایی کرده و به عنوان یک جامعه حل کنند.”

محققان در زمینه ایمنی هوش مصنوعی استدلال کردهاند که اگرچه به نظر میرسد افشای اطلاعات بیشتر به نفع دفاع سایبری است تا حمله سایبری، این ممکن است برای توسعه هوش مصنوعی صادق نباشد. در همین حال، تحقیقات اخیر نیز استدلال میکند که رویکرد متا برای استقرار مدل هوش مصنوعی کاملاً باز نیست، زیرا مجوز آن استفاده تجاری در مقیاس بزرگتر را ممنوع میکند و متا از نظر تجاری سود میبرد. از این رویکرد، زیرا از بهبود مدلهای خود توسط جامعه منبع باز بهره میبرد.

رهبری متا همچنین متقاعد نشده است که سیستمهای هوش مصنوعی قدرتمند میتوانند خطرات وجودی داشته باشند. مارک زاکربرگ، یکی از بنیانگذاران و مدیر عامل متا، گفته است که سناریوهای روز رستاخیز هوش مصنوعی را درک نمی کند و کسانی که این سناریوها را می سازند “بسیار غیرمسئولانه” هستند. Yann LeCun، برنده جایزه تورینگ و دانشمند ارشد هوش مصنوعی در Meta گفت که ترس از خطرات شدید هوش مصنوعی “به طرز عجیبی احمقانه” است.

Joelle Pineau، معاون تحقیقات هوش مصنوعی در Meta، به TIME گفت که تعهد به منبع باز به این معنی است که متا خود را با استانداردهای بالاتری حفظ می کند و می تواند محققان با استعداد بیشتری را جذب کند. پینیو اذعان کرد که مدلهای متا را میتوان به سلاح تبدیل کرد، اما قیاسی با امنیت سایبری ارائه کرد که در آن امنیت حفظ میشود زیرا تعداد بازیگران خوب بیشتر از بازیگران بد است.

او میگوید: «وقتی مدل را بیرون میآورید، بله، فرصتی برای کسی در زیرزمین ایجاد میکنید که سعی کند با آن چیزی بسازد. شما همچنین فرصتی برای هزاران نفر ایجاد می کنید تا به بهتر شدن مدل کمک کنند.

متا یکی از تنها توسعه دهندگان برجسته هوش مصنوعی است که به طور کامل از رویکرد منبع باز پشتیبانی می کند، اما بسیاری از گروه های با منابع کمتر نیز می خواهند دسترسی باز به سیستم های هوش مصنوعی را حفظ کنند. Yacine Jernite، یادگیری ماشینی و پیشرو جامعه در Hugging Face، به طور فزایندهای نگران عدم شفافیت و پاسخگویی است که شرکتهای توسعهدهنده هوش مصنوعی در حال حاضر با آن مواجه هستند، نگرانی مشترک بسیاری از مترقیها.

جرنیت میگوید: «سوال عملیاتی اصلی این است که چه کسی باید آژانس داشته باشد و چه کسی باید در مورد نحوه شکلگیری فناوری تصمیمگیری کند. و دو رویکرد برای آن وجود دارد: یکی اینکه میگوییم ما این شرکت را میسازیم، جایی که افرادی داریم که فکر میکنیم افراد خوبی هستند، زیرا آنها را استخدام کردهایم. و از آنجایی که آنها افراد خوبی هستند، فناوری خوبی خواهند ساخت، و باید برای ساخت آن فناوری به آنها اعتماد کرد. رویکرد دیگر این است که به فرآیندهای دموکراتیک نگاه کنیم… بخشی از دموکراسی این است که فرآیندهایی برای دید بیشتر، درک بیشتر و توازن مجدد قدرت بیشتر داشته باشد.

جرمی هوارد، یکی از بنیانگذاران fast.ai، یک گروه تحقیقاتی غیرانتفاعی هوش مصنوعی، بر ارزش های لیبرال کلاسیک در مورد سوالات هوش مصنوعی استدلال کرده است حکمرانی، با این ادعا که محدود کردن دسترسی به سیستمهای هوش مصنوعی، قدرت را تا حدی متمرکز میکند که خطر «بازگرداندن دستاوردهای عصر روشنگری» را به همراه خواهد داشت.

آدام تیرر، یکی از اعضای ارشد اندیشکده راست میانه و طرفدار بازار آزاد موسسه R Street، نوشته نحوه صدور مجوز و تلاش های دیگر برای تنظیم هوش مصنوعی می تواند نوآوری را خفه کند. تیرر همچنین به سطوح نظارت “اورولی” اشاره می کند که برای جلوگیری از آموزش سیستم های مرزی توسط توسعه دهندگان غیرمجاز هوش مصنوعی لازم است، و تردید دارد که کشورهای دیگر، به ویژه چین، از قوانین مشابه پیروی کنند.

نبرد پیش رو

همانطور که در حال حاضر وجود دارد، E.U. قانون هوش مصنوعی، که در حال انجام است در فرآیند قانونگذاری، به توسعه دهندگان “مدل های بنیادی” نیاز دارد – مدل های هوش مصنوعی که قادر به انجام طیف گسترده ای هستند. از وظایفی مانند Llama 2 و GPT-4 – برای اطمینان از انطباق سیستم های آنها با طیف وسیعی از استانداردهای ایمنی.

نیکلاس موس، مدیر مدیریت هوش مصنوعی اروپا در انجمن آینده، میگوید: این قانون یک رژیم مجوز را تحمیل نمیکند، اما میتواند از راههای دیگر منبع باز را مختل کند. برخلاف تعریف مدل مرزی که مورد علاقه بسیاری در ایالات متحده است، تعریف مدل پایه برای همه مدلهای هوش مصنوعی عمومی اعمال میشود، نه فقط قویترین آنها.

Moes میگوید: شرکتهای بزرگی مانند Meta باید بتوانند استانداردهای ایمنی را نسبتاً آسان رعایت کنند و اثرات آن بر توسعهدهندگان منبع باز کوچکتر با کاهش تعهدات برای سازمانهای کوچکتر جبران میشود. با این حال، در ماه جولای، گروهی از سازمانها از جمله Hugging Face و Eleuther AI، یک آزمایشگاه تحقیقاتی غیرانتفاعی، مقاله را منتشر کردند که در آن توصیههایی برای چگونگی اتحادیه اروپا ارائه میکرد. قانون هوش مصنوعی میتواند از توسعه هوش مصنوعی منبع باز، از جمله تعیین الزامات متناسب برای مدلهای پایه، پشتیبانی کند.

مقاله مقررات مدل مرزی نشان می دهد که بسیاری از رهبران صنعت با فشار دادن برای یک رژیم مجوز، خواستار رویکرد متفاوتی در ایالات متحده نسبت به اتحادیه اروپا هستند. متا و سایرین در ائتلاف که طرفدار یک رویکرد بازتر و شفاف تر برای توسعه هوش مصنوعی هستند، ممکن است برای توسعه دهندگان منبع باز تلاش کنند.

چاک شومر، رهبر اکثریت سنا رویکرد پیشنهادی خود را در مورد مقررات هوش مصنوعی در ژوئن رونمایی کرد و از کنگره خواست که به سرعت عمل کند. اما کنگره تنها یکی از میدان های نبرد در بحث های آینده است. تیرر میگوید: «من فکر میکنم همه اقدامات در آژانسها، دادگاهها و در سطح ایالتی در ایالات متحده انجام میشود. “و سپس در دنیای NGOها و تحولات تجاری و حاکمیت آن.”

اصلاح، ۷ سپتامبر

نسخه اصلی این داستان در جایی که مقاله با عنوان مقررات مدل مرزی برای اولین بار منتشر شد، اشتباه گفته شده است. این مقاله ابتدا در Arxiv منتشر شد، نه در وب سایت OpenAI.

منبع: Time